Chi siamo oggi è il risultato di un incredibile viaggio attraverso il tempo, un percorso segnato da scoperte rivoluzionarie, invenzioni sorprendenti e un’incessante voglia di progresso. Ma cosa succederebbe se potessimo scendere dalla macchina del tempo e indagare sulle radici della nostra esistenza tecnologica? Che storie ci racconterebbe il passato, tra gli ingranaggi degli antichi orologi e il ronzio dei primi computer? Benevenuti in un viaggio avvincente attraverso la Storia dell’Evoluzione della Tecnologia, un racconto affascinante che rivela come la nostra relazione con la tecnologia si sia sviluppata nel corso dei secoli.

Le Origini

Le radici della nostra relazione con la tecnologia affondano profondamente nelle ere antiche, dove gli esseri umani, guidati dalla curiosità e dalla necessità, hanno compiuto passi audaci verso l’innovazione. Uno dei primi capitoli di questa storia straordinaria è la scoperta del fuoco, un evento cruciale che ha illuminato il cammino dell’umanità in modi inimmaginabili. Questo elemento primordiale non solo ha fornito calore e sicurezza nelle notti oscure, ma ha anche dato inizio a un viaggio che avrebbe trasformato radicalmente il nostro modo di vivere. L’invenzione della ruota e degli strumenti primitivi ha segnato il passaggio a insediamenti più stabili, permettendo la creazione di comunità e la condivisione di risorse. L’adozione dell’agricoltura ha portato a una rivoluzione nella produzione alimentare e nella struttura sociale, mentre la scrittura ha fornito un mezzo permanente per registrare conoscenze e storie, consentendo la trasmissione di informazioni attraverso le epoche. L’emergere delle prime forme di metalworking ha dato luogo a utensili più resistenti, contribuendo all’evoluzione della tecnologia e della produzione. In questo intricato intreccio di scoperte, dalle prime comunità nomadi all’edificazione di opere architettoniche e al progresso nelle pratiche mediche, si intravedono i segni delle prime innovazioni che hanno portato allo sviluppo della tecnologia.

Un materiale che dà nome e unità tecnologica a questi periodi della preistoria è la pietra. Sebbene si possa presumere che gli esseri umani primitivi usassero altri materiali come legno, ossa e pelliccia per vari strumenti, nessuno di questi è sopravvissuto. Gli strumenti di pietra dei primi esseri umani, invece, sono sopravvissuti in sorprendente abbondanza, e nel corso dei molti millenni di preistoria sono stati compiuti importanti progressi nella tecnica nell’uso della pietra. Le pietre diventavano utensili solo quando venivano modellate deliberatamente per scopi specifici e, affinché ciò avvenisse in modo efficiente, era necessario trovare pietre adatte, dure e a grana fine, e ideare mezzi per modellarle e soprattutto per affilarle.La selce divenne una pietra molto popolare per questo scopo, sebbene fossero ampiamente utilizzate anche arenarie fini e alcune rocce vulcaniche. Ci sono molte prove paleolitiche di abilità nello sfaldare e lucidare le pietre per creare strumenti per raschiare e tagliare. Questi primi strumenti venivano tenuti in mano, ma gradualmente furono ideati modi per proteggere la mano dai bordi taglienti della pietra, inizialmente avvolgendone un’estremità in pelliccia o erba o inserendola in un manico di legno . Molto più tardi la tecnica di fissare la testa di pietra a un manico trasformò questi utensili manuali in strumenti e armi più versatili.

Con il crescente dominio del mondo materiale nel Neolitico, furono messe in servizio altri materiali, come l’argilla per la ceramica e i mattoni, e la crescente competenza nella manipolazione delle materie prime tessili portò alla creazione dei primi tessuti che sostituirono pelli di animali. Più o meno nello stesso periodo, la curiosità per il comportamento degli ossidi metallici in presenza del fuoco promosse una delle innovazioni tecnologiche più significative di tutti i tempi e segnò il passaggio dall’età della pietra all’età dei metalli.

L’Età dell’Antichità segna una fase epocale nella storia dell’evoluzione tecnologica, dove civiltà antiche hanno contribuito con scoperte che hanno influenzato il corso della storia. Le antiche civiltà dell’Egitto, della Mesopotamia, della Grecia e di Roma hanno dato vita a uno sviluppo di innovazioni che hanno lasciato un’impronta indelebile. L’Egitto ha spiccato per la sua maestria nell’ingegneria, realizzando le piramidi e sviluppando avanzate pratiche mediche. La Mesopotamia, tra Tigri ed Eufrate, ha visto la nascita della scrittura cuneiforme e l’invenzione della ruota. La Grecia antica ha prodotto menti brillanti come Archimede e Ippocrate, pionieri nelle scienze e nella medicina. Roma, con il suo ingegno nell’ingegneria e nella costruzione di strade, ha stabilito standard duraturi. In quest’epoca, la conoscenza ha attraversato confini, dando vita a un prezioso scambio culturale. L’avanzamento nelle arti, nelle scienze e nelle tecniche di costruzione ha lasciato un’eredità che ha resistito al trascorrere dei secoli, plasmando il nostro rapporto con la tecnologia e aprendo la strada a nuove possibilità nella storia dell’umanità.

Ada Lovelace & Charles Babbage

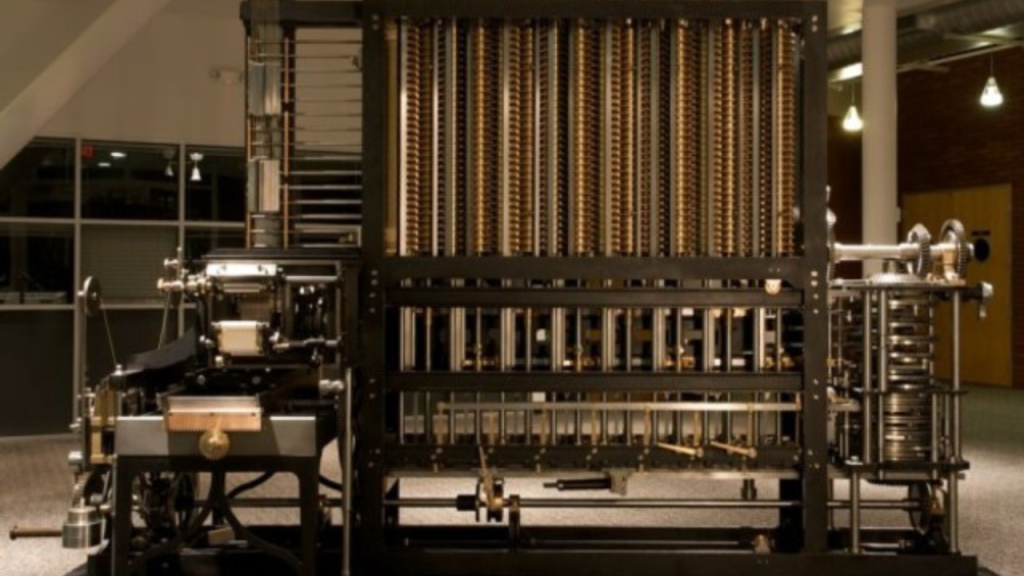

Sebbene Ada Lovelace sia vissuta in un’epoca distante dall’Antichità, la sua figura straordinaria collega le radici dell’innovazione alle prime fasi della rivoluzione tecnologica. Nel XIX secolo, Lovelace visionava le potenzialità del motore analitico di Charles Babbage, un concetto che avrebbe gettato le basi per il futuro digitale. Il suo lavoro non solo ha dimostrato l’interconnessione tra matematica e macchine, ma ha anche rappresentato il ponte tra antichi ingegni e le sfide dell’era industriale.

Nel 1842 Ada Lovelace redasse la sua unica pubblicazione professionale per la rivista Scientific Memoirs, che le aveva affidato la traduzione di un articolo scritto in francese dall’ingegnere militare italiano Luigi Menabrea in cui era descritta la macchina analitica di Babbage. Ada pubblicò l’articolo dove fornì le proprie teorie sul funzionamento della macchina di Babbage. Le note, firmate solo con le iniziali A.A.L. per celare la sua vera identità, non furono pubblicate a suo nome fino al 1953. Alla fine, queste estesissime note divennero più famose della traduzione stessa dell’articolo. Ma che cosa contenevano? L’immaginazione e la capacità di Ada di vedere oltre la realtà immediata la resero in grado di sviluppare diversi concetti che oggi potremmo dire visionari. Il più celebre si riferisce al funzionamento di quello che oggi è noto come algoritmo informatico. Ada prese a esempio i numeri di Bernoulli, che consistono in una serie infinita di cifre che giocano un ruolo importante nel descrivere, attraverso un diagramma, le operazioni che la macchina di Babbage avrebbe dovuto eseguire per poterle calcolare.

Di fatto fu Ada a introdurre quell’algoritmo nella macchina di Babbage, abbozzando un concetto informatico che oggi conosciamo come “iterazione” (un gruppo d’istruzioni che si eseguono più volte). Anche se non si può affermare categoricamente che Ada Lovelace sviluppò il primo programma informatico della storia, a differenza di Babbage fu comunque capace di vederne le conseguenze pratiche. Per esempio, fu sua l’idea di una macchina che si potesse programmare e riprogrammare per eseguire diverse funzioni, senza limitarsi semplicemente al calcolo, ma capace di eseguire qualunque compito che si potesse esprimere attraverso dei simboli.

Le Macchine Analitiche

L’ascesa delle macchine analitiche rappresenta un capitolo cruciale nella storia dell’evoluzione tecnologica, segnando il passaggio dalle prime forme di calcolo alla progettazione di dispositivi sempre più sofisticati. Dopo la visione di Ada Lovelace e del motore analitico di Charles Babbage, l’interesse per la realizzazione di macchine in grado di eseguire operazioni complesse ha guadagnato slancio.

Nel corso del XIX secolo, le menti illuminate iniziarono a sperimentare con dispositivi sempre più avanzati. George Boole sviluppò il calcolo booleano, un sistema logico che avrebbe fornito le basi teoriche per il funzionamento di circuiti elettrici nei computer moderni.

Nel 1848, con il libro The Mathematical Analysis of Logic, e con il libro del 1854, An Investigation of the Laws of Thought, Boole riprende e sviluppa l’idea che era stata di Leibniz, ovvero ridurre la logica ad algebra. Fonda così quella logica matematica che è la cornice teorica su cui si fonderanno non solo i Principia Mathematica di Alfred Whitehead e di Bertrand Russell del 1910-1913, ma anche l’idea di macchina universale di Alan Turing.

Ma i meriti di Boole non si esauriscono qui. Nei due libri che abbiamo citato egli propone un’algebra binaria, fondata su due sole variabili, vero o falso, e sull’utilizzo di pochi “operatori matematici”. Quindi propone anche il terzo elemento che si fonderà nella moderna informatica così come segnalato da Turing: il linguaggio. L“algebra booleana” è oggi a fondamento dell’elettronica digitale.

Questo periodo ha visto la costruzione di macchine analitiche sempre più complesse, come la macchina analitica differenziale di Vannevar Bush e il calcolatore di Thomas Fowler, che integravano metodi di calcolo differenziale e integrale.

L’ascesa delle macchine analitiche ha posto le basi per il futuro digitale, aprendo la strada a un’era in cui le macchine avrebbero svolto un ruolo sempre più centrale nella vita umana. Questi primi passi nella programmazione elettronica e nelle macchine calcolatrici hanno gettato le fondamenta per la rivoluzione digitale che avrebbe trasformato radicalmente la società nel XX secolo.

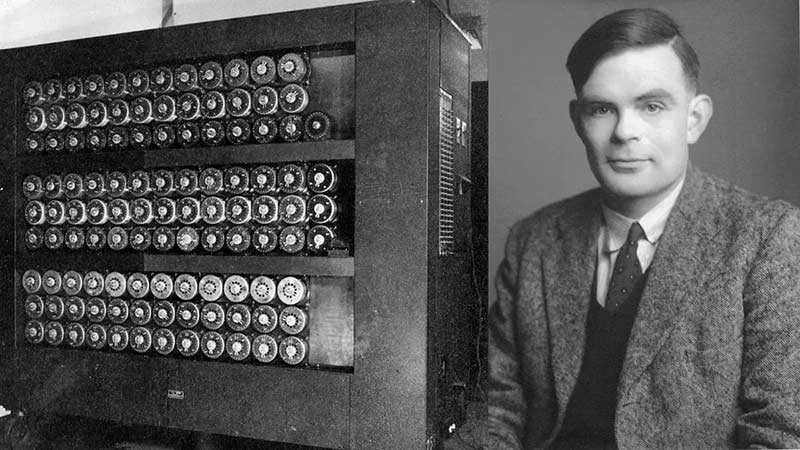

Alan Turing

Tutto inizia nel 1938, quando poco all’inizio della Seconda Guerra Mondiale, e un gruppo composto da centinaia di matematici e logici chiede aiuto ad Alan Turing, un matematico e informatico inglese, per decifrare i codici dei tedeschi, anticipare le loro mosse e provare a salvare le vite umane.

I messaggi cifrati vengono prodotti con Enigma, un macchinario inventato dall’ingegnere Arthur Scherbius. È un macchinario composto da una tastiera normale e una seconda tastiera in cui ogni lettera è illuminata da una lampadina. Inizialmente viene venduta legalmente in tutta Europa, ma con lo scoppio della Guerra molte macchine di questo tipo vengono modificate e usate per nascondere le comunicazioni.

Per decifrare un messaggio è necessario possedere due macchine, una per la codifica e una per la decodifica perché le lettere digitate su questa macchina da scrivere vengono trasformate in altre lettere, quelle illuminate dalle lampadine.

Alan cerca allora di decifrare i messaggi criptati dei nemici. Insieme al suo gruppo di colleghi, tra cui il matematico Gordon Welchman, crea “The Bombe”. The Bombe funziona perché cerca le possibili impostazioni corrette dei rotori utilizzate dai tedeschi e poi esclude quelle in cui si generano contraddizioni. Così, andando per esclusione, Alan decripta i messaggi dei nemici.

Tra il 1943 e il 1944, i matematici Maxwell Newman e Tommy Flowers progettano Colossus, l’antenato degli odierni computer, con lo scopo di sbaragliare la nuova versione di Enigma.

Il lavoro di Alan e i suoi colleghi fu importantissimo per la vittoria degli alleati e permette di salvare moltissime vite.

Macchine Calcolatrici

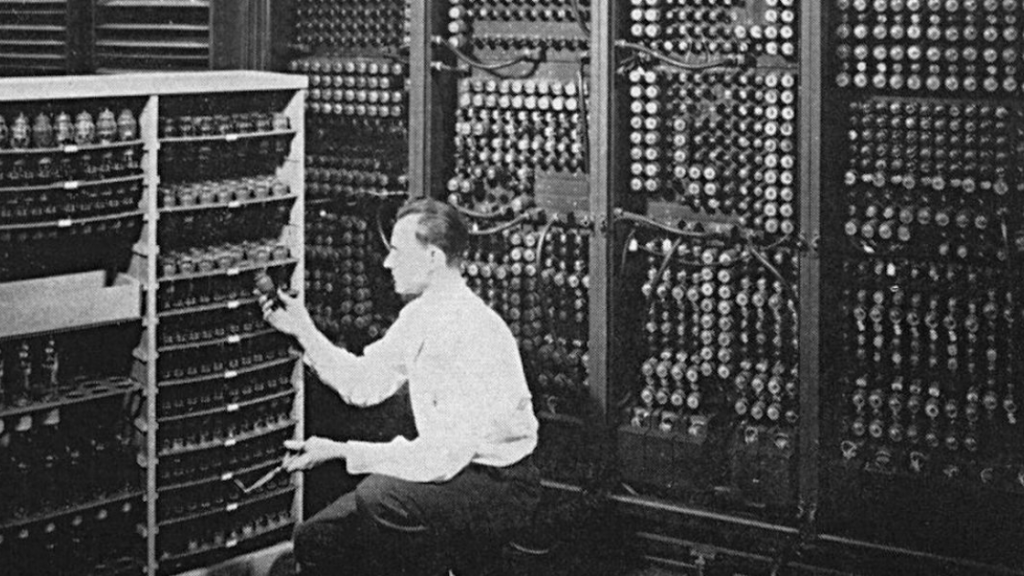

Dopo la Seconda Guerra Mondiale, il focus sull’informatica si spostò dai laboratori di ricerca teorica alla costruzione di macchine calcolatrici. Centri di ricerca informatica divennero luoghi chiave per sviluppare i primi computer funzionanti. Macchine come l’EDSAC (Electronic Delay Storage Automatic Calculator) e l’ENIAC (Electronic Numerical Integrator and Computer) segnarono il passo verso l’applicazione pratica delle idee teoriche di Turing.

Nel giugno del 1942 il Dipartimento dell’esercito degli Stati Uniti affidò al fisico Mauchly dell’università della Pennsylvania e al giovane ingegnere elettronico Eckert il “Progetto PX” per la costruzione dell’Eniac.

Nei tre anni seguenti, nei laboratori della Moore School of Electrical Engineering, venne assemblata una macchina al cui interno c’erano 18.800 valvole a vuoto, 70.000 resistori, 10.000 condensatori, 1500 relè, 6000 interruttori manuali e 5 milioni di giunti saldati: le componenti elettroniche destinate a creare il sistema digitale che avrebbe permesso poi l’elaborazione dei calcoli. Il tutto racchiuso in una struttura di 42 pannelli alti 2,7 metri e spessi 33 centimetri in lamiera di acciaio verniciata di nero, dal peso di 27 tonnellate e che occupava una superficie di 167 metri quadri, dotata di tubi di aerazione nella parte superiore per il raffreddamento e la circolazione dell’aria e una linea di alimentazione dedicata.

Gli ingegneri erano preoccupati per la presenza di numerosi tubi e componenti elettronici, temendo difetti e malfunzionamenti durante i calcoli. Per risolvere questo problema, la macchina fu costruita con moduli collegati tra loro, facilitando il rilevamento e la sostituzione delle unità difettose. Grazie a continui test, il tasso di fallimento passò da due volte al giorno a una volta ogni due giorni, riducendo gradualmente gli errori e i malfunzionamenti. Questo perfezionamento consentì alla macchina di eseguire calcoli ed elaborazioni in modo più preciso.

Le capacità dell’ENIAC emersero immediatamente in modo evidente: fu il primo computer a scopo generale, in grado di gestire una vasta gamma di calcoli matematici relativi a problemi generici. Questo segnò l’inizio dei moderni PC e della programmazione informatica, come la conosciamo oggi.

Un’altra svolta cruciale fu rappresentata dall’introduzione dell’architettura di von Neumann. Questa architettura, che è alla base della progettazione di quasi tutti i computer moderni, ha permesso una maggiore flessibilità nell’esecuzione di diversi tipi di programmi e algoritmi.

Le caratteristiche dell’architettura di von Neumann includono un unico controllo centralizzato, alloggiato nell’unità centrale di elaborazione, e un’area di archiviazione separata, la memoria primaria, che può contenere sia istruzioni che dati. Le istruzioni vengono eseguite dalla CPU e quindi devono essere importate nella CPU dalla memoria primaria. La CPU ospita anche l’unità che esegue operazioni, ovvero l’unità aritmetica e logica (ALU), quindi i dati devono essere recuperati dalla memoria primaria e portati nella CPU per poter essere utilizzati. La memoria primaria ha un meccanismo di indirizzamento integrato, in modo che la CPU possa fare riferimento agli indirizzi di istruzioni e operandi.

La fluida interazione dei componenti contribuisce al funzionamento efficiente di un sistema informatico costruito sui principi dell’architettura Von Neumann.

L’architettura Von Neumann è stata ampiamente adottata in vari sistemi informatici e applicazioni grazie alla sua semplicità, flessibilità e compatibilità. Alcune applicazioni comuni includono:

- Personal computer e laptop: la maggior parte dei moderni PC e laptop utilizzano l’architettura Von Neumann per l’elaborazione centrale e gestione della memoria.

- Microcontrollori: questi piccoli computer sono integrati in un’ampia gamma di dispositivi elettronici, come elettrodomestici, sistemi automobilistici e apparecchiature di automazione industriale. La semplicità e la scalabilità dell’architettura Von Neumann la rendono ideale per l’implementazione del microcontrollore, poiché può essere facilmente adattata per soddisfare i requisiti specifici di ciascuna applicazione.

- Sistemi integrati: Simili ai microcontrollori, i sistemi embedded sono sistemi informatici progettati per compiti specifici e sono spesso integrati in dispositivi o sistemi più grandi. Tali sistemi in genere hanno risorse limitate e richiedono un uso efficiente della memoria e delle capacità di elaborazione, il che è facilitato dall’architettura Von Neumann.

- Supercomputer e cluster di calcolo ad alte prestazioni: Molti supercomputer e cluster di calcolo utilizzano ancora i principi di questa architettura nella loro progettazione. Modifiche, come l’uso di più processori avanzati e gestione della memoria, aiutano a mitigare le limitazioni intrinseche e forniscono le prestazioni necessarie per attività computazionalmente intensive.

Konrad Zuse e lo Z3

Dopo il periodo dell’ENIAC e dell’architettura di von Neumann, un altra figura importante dell’informatica merita attenzione, ovvero Konrad Zuse, un ingegnere tedesco, che contribuì in modo significativo nel mondo dell’informatica con la costruzione del Computer Z3, considerato il primo computer elettromeccanico programmabile.

Zuse completò la costruzione del Z3 nel 1941, introducendo concetti chiave come l’uso di un nastro perforato per programmare le operazioni del computer. Questo fu un passo importante verso la programmabilità, anticipando la direzione che avrebbe preso lo sviluppo dei computer nelle successive fasi.

Durante la Seconda Guerra Mondiale, Zuse lavorò su progetti più avanzati, sviluppando il Computer Z4, che fu il primo computer a essere utilizzato operativamente. Le sue innovazioni includevano il concetto di “plankalkül“, un linguaggio di programmazione teorico, anche se non implementato all’epoca.

Zuse continuò a contribuire alla teoria dei computer e alla progettazione di macchine calcolatrici, ma il suo lavoro non ottenne riconoscimento internazionale fino a dopo la guerra. La sua esperienza nel campo dell’informatica fu unico e stimolante, portando avanti idee che influenzarono lo sviluppo successivo della disciplina.

Logic Theorist

Nel 1955 Simon e Newell discussero la possibilità di insegnare alle macchine a pensare. Queste discussioni hanno dato vita a un programma in grado di dimostrare teoremi matematici. Doveva essere progettato specificamente per imitare l’abilità di risoluzione dei problemi esibita da persone reali. Il risultato è stato un programma in grado di pensare come un vero matematico umano. Tuttavia, per far funzionare il programma, Simon e Newell avrebbero bisogno dell’aiuto di un programmatore di computer.

Per scrivere i codici, Newell ha chiesto aiuto a John Clifford Shaw, un programmatore di computer della RAND, per sviluppare il programma. Cliff Shaw ha scritto i codici per il Logic Theorist utilizzando una prima versione di IPL (Information Processing Language), un linguaggio di programmazione in esecuzione su un computer della struttura di ricerca di Santa Monica della RAND. Nel 1956, il Logic Theorist era finalmente pronto per l’uso. Tuttavia, l’occasione perfetta per mostrare davvero l’invenzione al mondo si sarebbe presentata pochi mesi dopo la sua realizzazione.

Quando venne costruito il Logic Theorist, il campo dell’intelligenza artificiale non esisteva e fu semplicemente coniato da John McCarthy durante l’estate del 1956 per una conferenza organizzata al Dartmouth College in collaborazione con Marvin Minsky e Claude Shannon.

WWW – World Wide Web

Tim Berners-Lee, uno scienziato britannico, ha inventato il World Wide Web (WWW) nel 1989. Il Web è stato originariamente concepito e sviluppato per soddisfare la domanda di condivisione automatizzata delle informazioni tra scienziati nelle università e negli istituti di tutto il mondo.

Tim Berners-Lee ha scritto la prima proposta per il World Wide Web nel marzo del 1989 e la seconda nel maggio 1990. Insieme all’ingegnere Robert Cailliau, questa venne formalizzata come proposta di gestione nel novembre 1990. Questa delineava i concetti principali e definiva i termini importanti dietro il Web. Il documento descriveva un progetto ipertestuale chiamato World Wide Web, in cui “una rete di documenti ipertestuali poteva essere visualizzata dai browser”.

Alla fine del 1990, Tim Berners-Lee aveva installato il primo server Web e browser al CERN, dove lavorava all’epoca, dimostrando le sue idee.

La progettazione del WWW ha consentito un facile accesso alle informazioni esistenti e una prima pagina web collegata a informazioni utili agli scienziati del CERN.

Il browser Web originale di Berners-Lee in esecuzione mostrava la sua visione e aveva delle funzionalità dei browser Web attuali. Inoltre, includeva la possibilità di modificare le pagine direttamente dal browser: la prima funzionalità di editing Web.

Apple & Microsoft

La storia di Apple e Microsoft rappresenta un capitolo iconico nella rivoluzione dell’informatica e nella crescita dell’industria tecnologica. Fondate a pochi anni di distanza l’una dall’altra, entrambe le società hanno svolto ruoli cruciali nella diffusione dei computer e nella creazione di prodotti che hanno cambiato la vita quotidiana delle persone.

Apple, fondata nel 1976 da Steve Jobs, Steve Wozniak e Ronald Wayne, è emersa come un’icona di innovazione e design. La società ha ottenuto successi iniziali con l’Apple I e l’Apple II, uno dei primi computer personali, ma è stata la creazione del Macintosh nel 1984 a segnare un punto di svolta nell’interfaccia utente e nel design. La presentazione del primo iPod nel 2001 e, successivamente, dell’iPhone nel 2007 e dell’iPad nel 2010, ha rafforzato il ruolo di Apple come leader nell’industria dei dispositivi personali e dell’intrattenimento digitale.

Microsoft, fondata nel 1975 da Bill Gates e Paul Allen, ha concentrato la sua attenzione sulla creazione di software. Il sistema operativo MS-DOS, acquisito da IBM, ha segnato l’inizio del successo per Microsoft, diventando la base per il sistema operativo Windows lanciato nel 1985. Windows ha dominato il mercato dei sistemi operativi per computer personali e ha consolidato la posizione di Microsoft nell’industria del software.

Oggi, Apple e Microsoft sono tra le società più influenti al mondo, con una vasta gamma di prodotti e servizi. La loro storia è intrecciata con lo sviluppo della tecnologia moderna e ha contribuito all’evoluzione del panorama digitale in cui viviamo oggi.

Primo Smartphone

Quasi 40 anni fa, Motorola presentò il DynaTAC 8000X, il primo telefono cellulare e rappresenta un grande passo nell’evoluzione dello smartphone, ma il primo vero e proprio smartphone della storia venne presentato da IBM.

Il 23 novembre 1992 IBM presentò alla fiera informatica di Las Vegas il primo smartphone della storia. Aveva un display in bianco e nero ed era in grado per la prima volta sia di inviare che di ricevere mail, aveva una calcolatrice, un blocco per le note e anche alcuni semplici giochi. Si chiamava Simon Personal Communicator e venne lanciato sul mercato solo due anni dopo, nel 1994, a un prezzo di 900 dollari.

Ovviamente non aveva nulla a che vedere con gli smartphone che usiamo oggi: la risoluzione era di 160×293 pixel, e poteva contare su 1 MB di RAM. Il problema era soprattutto la batteria, che si scaricava in pochissimo tempo. Ovviamente, sia per il numero di utenti che per le poche funzionalità a livello di capacità, funzioni, memoria e connessione, i numeri del primo smartphone della storia erano abbastanza negativi, soprattutto rispetto a quelli di oggi. Ma nonostante questo, si trattò di un’innovazione tecnologica epocale, che aprì le porte al futuro e ai nostri attuali telefoni.

Tecnologia al giorno d’oggi

Al giorno d’oggi, ci troviamo in un momento di accelerato progresso tecnologico, dove l’innovazione costante sta cambiando ogni aspetto della nostra vita quotidiana. L’ascesa di tecnologie come l’intelligenza artificiale sta ridefinendo il nostro modo di vivere, lavorare e connetterci con il mondo.

L’intelligenza artificiale, alimentata da algoritmi avanzati e capacità di apprendimento automatico, è sempre più integrata in servizi e prodotti. Dalle raccomandazioni personalizzate negli streaming ai chatbot intelligenti nell’assistenza clienti, l’IA sta ottimizzando le nostre interazioni digitali e migliorando l’efficienza in settori come la sanità, la finanza e la ricerca scientifica.

La realtà aumentata sta guadagnando terreno nell’intrattenimento, nella formazione e in molte altre applicazioni. Con la capacità di sovrapporre informazioni digitali al mondo fisico, la AR sta arricchendo esperienze visive e interazioni quotidiane, portando nuove possibilità nella comunicazione e nella condivisione di conoscenze.

La realtà virtuale, d’altra parte, offre esperienze immersive che vanno ben oltre l’intrattenimento. Dalla formazione virtuale all’architettura e alla progettazione industriale, la VR sta rivoluzionando il modo in cui interagiamo con il digitale, portando una nuova dimensione di coinvolgimento e comprensione.

I computer e gli smartphone sono sempre più potenti, ogni anno vengono migliorati e vengono aggiunte nuove funzionalità, con l’implementazione dell’Intelligenza Artificiale, che consentono ai nostri dispositivi di aiutarci sempre di più.

L’esplorazione della storia della tecnologia ci ha condotto attraverso una straordinaria odissea di innovazione e cambiamento, cambiando il nostro mondo in modi che sarebbero sembrati impensabili solo pochi decenni fa. Dall’avvento dei primi calcolatori elettronici alle attuali frontiere dell’intelligenza artificiale, abbiamo assistito a una trasformazione senza precedenti, guidata dalla creatività umana e dalla continua ricerca di soluzioni avanzate.

L’avvento degli smartphone ha portato il potere della connettività globale nelle nostre mani, cambiando radicalmente la nostra interazione con l’informazione e tra di noi. Apple, Microsoft e altre aziende sono diventate architetti di questo cambiamento.

Le tecnologie emergenti, come l’intelligenza artificiale, la realtà aumentata e la realtà virtuale, ci stanno catapultando in una nuova era di possibilità. Mentre sfruttiamo l’IA per ottimizzare processi e servizi, la realtà aumentata arricchisce il nostro mondo quotidiano di informazioni digitali interattive.

La storia della tecnologia è un racconto di creatività, risoluzione di problemi e adattamento costante. Mentre salutiamo il passato e riconosciamo il presente, ci troviamo di fronte a un futuro di straordinarie opportunità.

In questo viaggio in continua evoluzione, ciò che è certo è che la tecnologia continuerà a guidarci verso orizzonti ancora inesplorati.

Presented By: FM TECH NEWS

Lascia un commento